Prerequisite

- ROCm 6.3.0 이상 세팅

- AMD GPU 사용

참고

https://youtu.be/Wjrdr0NU4Sk?si=gDCpm9T4ylqlqeax

AMD GPU 용 Ollma를 세팅한 후 open-webui 로 chatgpt 처럼 사용

docker-compose.yml 생성

services:

open-webui:

image: 'ghcr.io/open-webui/open-webui:main'

restart: always

environment:

OLLAMA_BASE_URL: "http://ollama:11434" # <- 이 부분을 추가

container_name: open-webui

ports:

- '30000:8080' #30000번으로 포워딩

volumes:

- './data/open-webui:/app/backend/data'

ollama:

image: 'ollama/ollama:rocm' #rocm 버전

restart: always

volumes:

- './data/ollama:/root/.ollama'

ports:

- '11434:11434'

devices:

- "/dev/kfd"

- "/dev/dri"

group_add:

- "${RENDER_GROUP_ID:-992}"

- "video"

compose up

sudo docker compose up

http://localhost:30000 으로 접속, 계정 생성

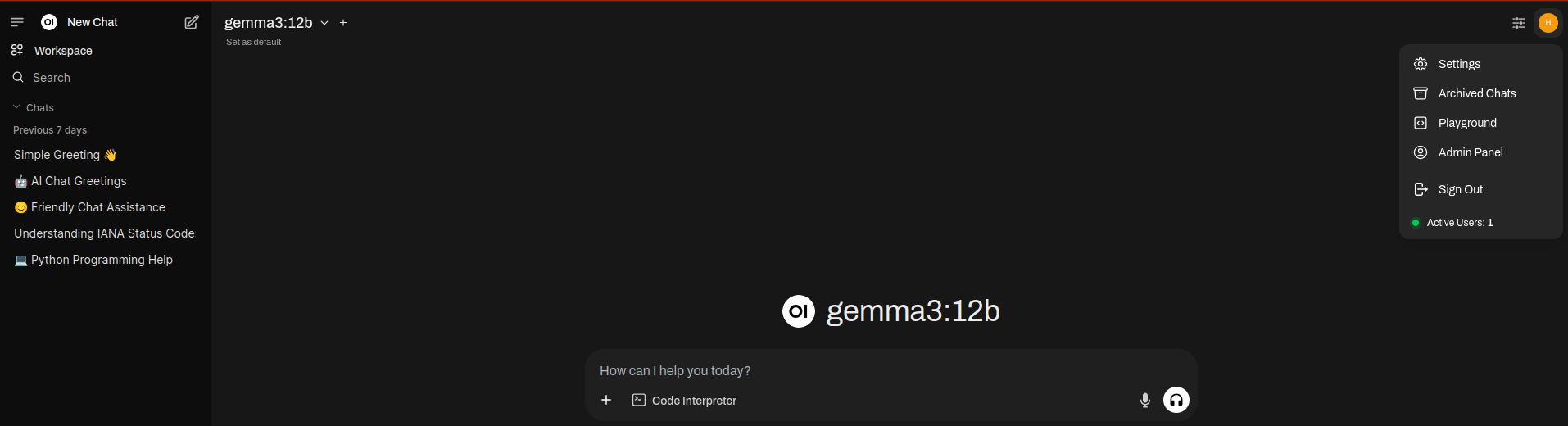

모델 추가를 위해 우측 상단 setting으로 이동 (현재 gemma3:12b가 이미 로드된 상태)

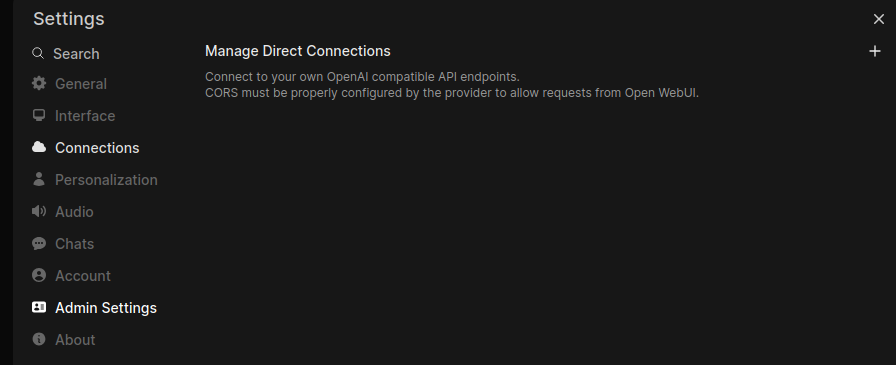

Admin setting으로 이동

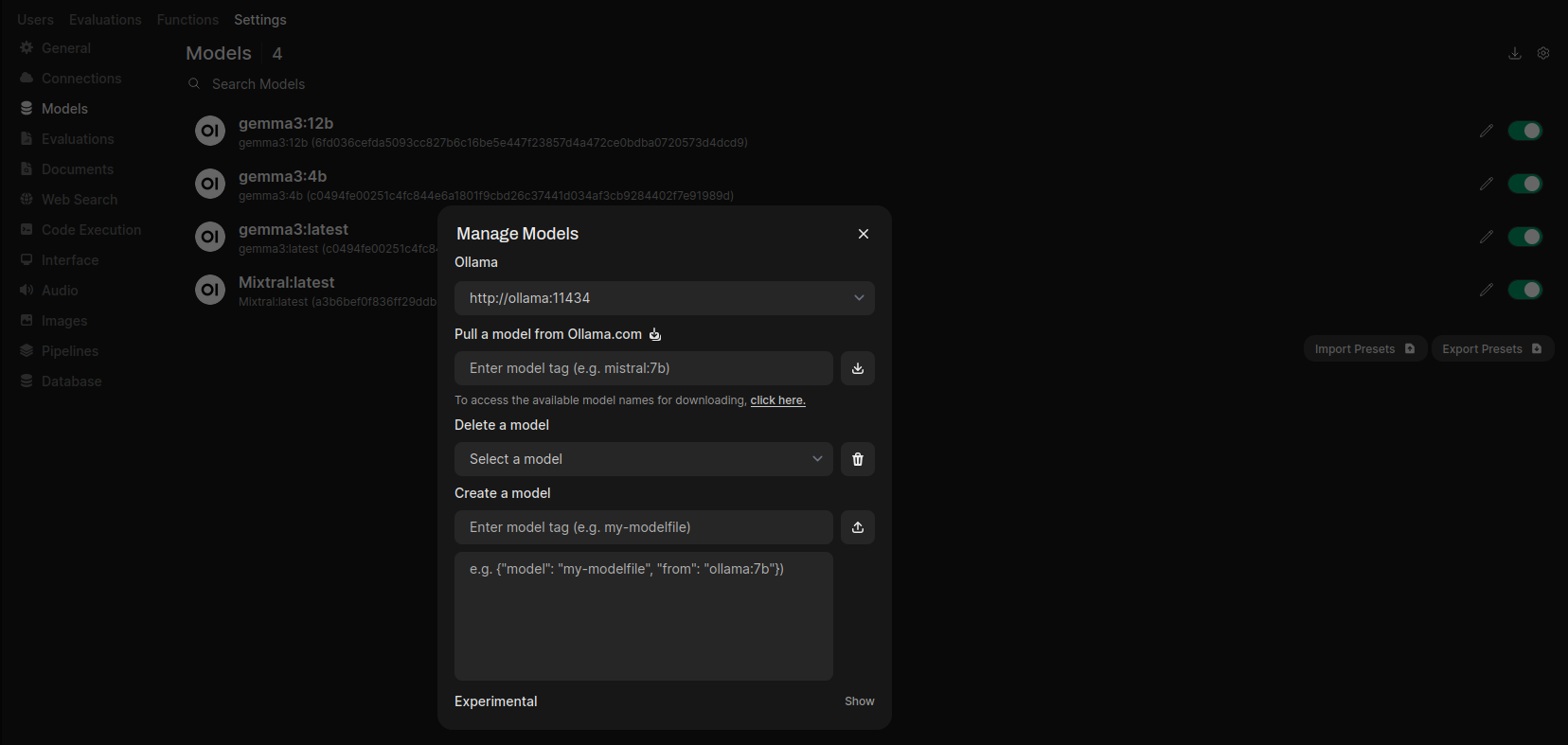

아래 사진의 우측 상단 다운로드 표시를 누르면 모델 추가 가능

*뒷 링크에서 모델 살펴보기 및 이름 확인 가능, https://ollama.com/library

library

Browse Ollama's library of models.

ollama.com

'컴퓨터 > 머신러닝 (Machine Learning)' 카테고리의 다른 글

| 하드 디스크 병목으로 인한 CPU 사용량 저하 확인 (0) | 2024.05.23 |

|---|---|

| Yolov9 Jupyter에서 돌려보기 (1) | 2024.05.15 |

| Ubuntu, ROCm, AMD GPU, Docker, Tensorflow, 환경에서 JAX 세팅 정리 (0) | 2022.12.28 |

| Pytorch distributed launch watchdog timeout 에러 해결 (0) | 2022.12.27 |

| Super resolution 모델, HAT train 정리 (0) | 2022.12.26 |